伴随着科学技术的发展,诸多曾仅存于科幻电影中的人类梦想,已逐步照进现实。在商业航空领域,X-Space火箭升空,让“平民”的太空旅行成为可能;元宇宙领域,英伟达、Meta、微软等巨头持续推进相关研发,脑机接口技术在医疗领域的应用;人工智能领域,脑机接口实现重大突破……这些令人振奋的“奇迹”,给半导体产业带来了新的发展契机,也同时带来了巨大的“算力焦虑”。那么,对大众来说,何为算力?算力的多寡究竟会给我们的生活带来怎样的影响?

算力凶猛

计算是人类认知世界的一种模式,从个人电脑到大型数据中心,从智能手机到可穿戴设备,计算能力正在一步步拓展着人类的认知与能力范畴。而计算能力,就是我们常说的“算力”。随着5G、人工智能、物联网、区块链等新兴技术的发展,人类社会朝着智能化和数字化方向迈进,并掀起了一场以“算力”为核心的竞赛。

算力无处不在。从军工、航天、工业、能源到寻常百姓的生活,算力隐藏在我们耳熟能详的名词背后:智能驾驶系统、AI、云计算、IoT、区块链、元宇宙、智慧城市、智慧农业、健康码、核酸检测、疫苗……这一切都离不开算力的支持。算力甚至改变了传统的生物保护方式。还记得去年,一群大象历时17个月的奇幻冒险吗?为了促进亚洲象更好地适应环境,西双版纳甚至调用了人工智能计算中心来监测亚洲象的活动情况。

中国科学院有关专家表示,自然保护区的专家们不需要再去通过大象的足印、粪便、吃剩的食物残渣推断个体数量、分布范围和饮食习惯。基于人工智能模型,可以对亚洲象进行全天候的观测和精准识别,不仅有利于缓解人象冲突,也基于观测结果为食源地优化和亚洲象国家公园的区域规划提供科学参考,充足的算力,让“人象共生”成为可能。

今天,算力被广泛应用在世界的各个领域。那么,算力够用吗?答案是NO。

算力VS数据:一场旷日持久的龟兔赛跑

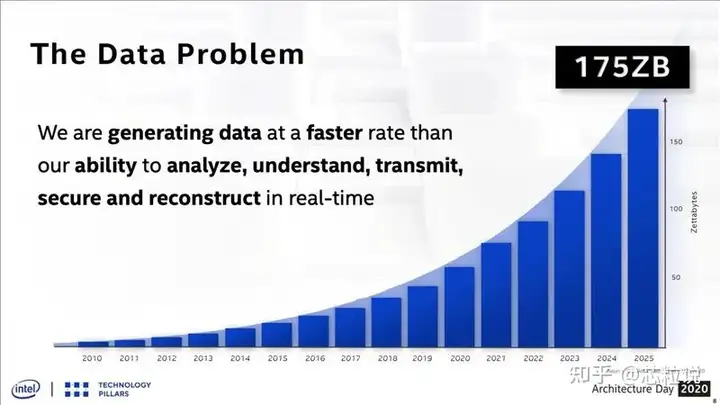

供不应求是一切焦虑的来源,算力领域也是如此。电脑、移动设备不间断地生成大量数据,全球的数据规模已达到了 ZB(Zettabyte) 级。IDC公司发布的DataSphere和StorageSphere报告显示,2020年全球产生了超过64ZB数据量;到2025年,全球数据总量将增至175ZB,较2010年的全球的数据总量增加175倍。反观算力增长,仅以AI产业为例,“用于AI测试的全球的算力需求每3.5个月就会翻一倍,远远超过了当前算力的增长速度。”工信部下属机构赛迪智库发布的《先进计算产业发展白皮书》显示,国内数字经济在国民经济中占比已经超过30%,未来算力缺口巨大。算力和数据增长的关系,就如同一场旷日持久的龟兔赛跑。

人类创造的数据量(Source:Intel Architecture Day 2020)

从存储到分析:算力重心转型

依托互联网和移动互联网的发展,和无处不在的电子设备,人们日常工作生活所留下的“痕迹”被物联网设备完整收集,最终汇聚而成的数据集就是“大数据”。得益于处理和存储能力的飞跃,今天,大数据为国家、企业、组织带来了前所未有的机会,通过数据分析,揭示数据中的隐藏规律,能帮助人们做出更明智的决策。

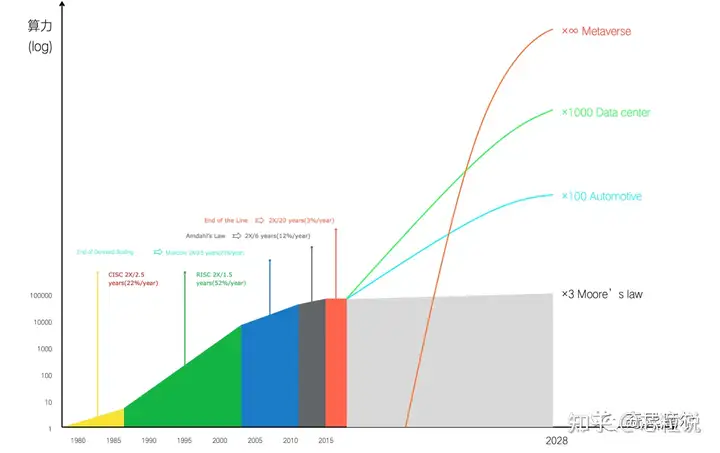

经过多年的发展,大数据的处理重心逐渐以存储、传输为中心向数据分析转变。作为提供多样化计算能力支撑的新型基础设施,数据中心被委以重任。从应用层面说,从图形视频到云游戏、自动驾驶到智能机器人、数据分析到AI训练及推理,下一代数据中心面对的数据不仅数量庞大,多样性和复杂性也越来越高。据估算,下一代数据中心在5年内将面临约1000倍的算力需求。

从辅助驾驶到全自动驾驶有多远?

今年1月,通用汽车和英特尔子公司Mobileye宣传,面向消费者的无人驾驶汽车或在2025年出现,Mobileye开发了专用于电动汽车四级自动驾驶的高级芯片,直接对标特斯拉的“全自动驾驶”愿景。越来越多的巨头进入全自动驾驶领域,真正的无人驾驶已不再遥远。

无人驾驶为人们带来了无限可能,但要使真正的无人驾驶汽车成为现实,仍然需要克服一些关键挑战。为了使汽车“眼观六路耳听八方”,人工智能或机器学习模型需要正确收集、结构化并理解大量视频、图像、音频、文本等数据。而其中最大的挑战便在于处理这些生成的数据量,并得出正确的决策。

今年3月,由Auto Byte举办的“首席智行官大会”上,来自多家汽车产业链公司的高管提出了“软件定义汽车,硬件定义软件天花板”的说法,并指出由这两者共同决定的“算力”已是制约当前自动驾驶向前发展的重大考验。

随着自动驾驶从L1(辅助驾驶)、L2(部分自动化)时代逐渐向L3(有条件自动化)、L4(高度自动化)、L5(完全自动化)发展,随之产生的数据量激增,算法也更加复杂。在未来,预计1000 TOPS将成L4、乃至L5级自动驾驶的算力标配。而现阶段很多单颗芯片算力仍小于10 TOPS,算力缺口可见一斑。

元宇宙,是幻梦还是不远的未来?

各大科技巨头纷纷布局元宇宙。微软以687亿美元收购暴雪,称该交易将“为元宇宙提供基础”;Facebook创始人扎克伯格将赌注押在元宇宙上,并将他的社交网络公司改名为Meta(元);Google多年来一直致力于同元宇宙相关的技术;苹果也在开发自己的相关设备。元宇宙向我们描绘了一幅面向未来的数字世界的画卷,但元宇宙真的能实现吗?

纽约虚拟现实世界的一位体验者 JEENAH MOON FOR THE NEW YORK TIMES

元宇宙是虚拟现实和数字第二人生的两个概念的融合。在虚拟现实中,你可以戴上头盔,沉浸在3D环境中,并使用动作感应控制器、麦克风与虚拟对象进行交互。风险投资家马修·鲍尔说,元宇宙代表了继大型机计算、个人计算和移动计算之后的第四次计算机浪潮。

理想很丰满,但现实是,人类几乎没有足够的处理能力来实现元宇宙。英特尔高级副总裁兼加速计算系统和图形部门负责人 Raja Koduri 称「我们今天的计算、存储和网络基础设施根本不足以实现这一愿景。」据预测,元宇宙将需要至少10的6次方倍于目前的算力,而元宇宙的终极理想形式,对算力资源的需求近乎无限。这场算力革命,我们任重道远。

从摩尔定律停滞到算力破局

事实上,算力焦虑并非一直存在,只是在近些年,算力增长的速度变慢了。至少在上世纪80、90年代,人们还远比现在乐观得很,这种乐观来自于著名的摩尔定律。

1965年,一位名为戈登-摩尔的年轻工程师预言,集成电路上的晶体管数量将每两年翻一番。在摩尔定律的指导下,计算机从笨重的大块头,发展至今天轻薄的智能手机。按照摩尔定律当年的预测,消费者将每年都可以用更少的钱买到性能翻番的电子产品,我们所盼望的“科幻未来”也指日可待。而如今,这种理所当然的乐观已荡然无存,CPU性能提升降至每年不足3%,实现性能翻倍需20年。

算力增长曲线

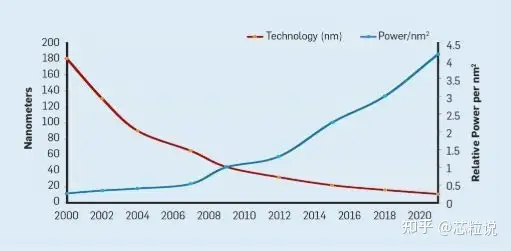

Dennard Scaling停滞:无独有偶,就在摩尔定律放缓的同时,它的兄弟定律Dennard缩放比例定律也失效了。按照该定律预测,随晶体管密度的增加,每个晶体管的功耗会下降,硅的功耗恒定。而由于硅的计算能力随着每一代新技术的发展而提高,计算机将变得更加节能。遗憾的是,Dennard Scaling在2007年开始显著放缓,到2012年几乎为零。

摩尔定律和Dennard Scaling相继失效后,CPU性能提升速度大幅放缓,制造商开始将重点转向多核处理器,以提高芯片性能,第一个双核芯片由此诞生,接下来是四核、八核。然而,不断增加芯片引发了严重的散热问题。通过多核提高性能的方式并没有解决根本问题。

随着时间的推移,算力的缺口越来越大,围绕新工艺、新封装、新架构、新材料等趋势,半导体行业开始不断寻求突破算力增长限制的关键创新。原来通用处理器一统天下的局面被打破,更多专用算力横空出世。

今天,多元和异构已成为当下算力的特点。其中,超异构计算及其核心技术之一“Chiplet”被业界寄予厚望,被认为或将从另一个维度延缓摩尔定律。

更多信息,请关注公众号: